Agi e Intelligenza Artificiale. Un nuovo modello di intelligenza artificiale (IA) ha appena ottenuto risultati a livello umano in un test progettato per misurare l’intelligenza generale.

Il 20 dicembre, il sistema o3 di OpenAI ha raggiunto l’85% nel benchmark ARC-AGI, ben oltre il precedente miglior risultato di un’IA, pari al 55%, e in linea con il punteggio medio umano. Inoltre, ha ottenuto ottimi risultati in un difficile test di matematica.

La creazione di un’intelligenza artificiale generale (AGI) è l’obiettivo dichiarato di tutti i principali laboratori di ricerca sull’IA. A prima vista, sembra che OpenAI abbia fatto un passo significativo verso questo traguardo.

Nonostante il persistente scetticismo, molti ricercatori e sviluppatori nel campo dell’IA ritengono che qualcosa sia appena cambiato. Per molti, la prospettiva dell’AGI sembra ora più reale, urgente e vicina di quanto previsto. Hanno ragione?

Generalizzazione e intelligenza

Per capire cosa significhi il risultato dell’o3, bisogna comprendere cosa misura il test ARC-AGI. In termini tecnici, si tratta di un test che valuta l’efficienza campionaria di un sistema di IA nell’adattarsi a qualcosa di nuovo: quanti esempi di una situazione inedita il sistema deve osservare per capirne il funzionamento.

Un sistema come ChatGPT (GPT-4) non è molto efficiente da questo punto di vista. È stato “addestrato” su milioni di esempi di testo umano, costruendo regole probabilistiche su quali combinazioni di parole siano più probabili.

Questo lo rende efficace in compiti comuni, ma meno performante in compiti insoliti, dove i dati disponibili (campioni) sono limitati.

Fino a quando i sistemi di IA non saranno in grado di imparare da pochi esempi e adattarsi con maggiore efficienza campionaria, saranno utilizzati solo per compiti molto ripetitivi o per quelli in cui è tollerabile un eventuale fallimento.

La capacità di risolvere con precisione problemi nuovi o sconosciuti partendo da pochi dati è nota come capacità di generalizzazione. È ampiamente considerata un elemento necessario e fondamentale dell’intelligenza.

Griglie e schemi

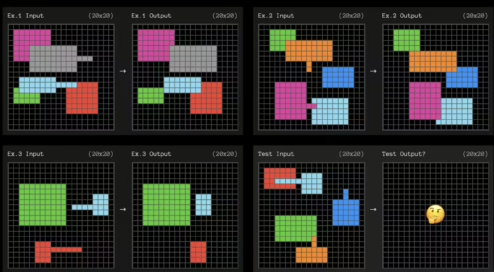

Il benchmark ARC-AGI testa l’adattamento efficiente con problemi basati su griglie, come quello mostrato di seguito. L’IA deve individuare lo schema che trasforma la griglia di sinistra in quella di destra.

Ogni domanda fornisce tre esempi da cui imparare. Il sistema di IA deve quindi identificare le regole che “generalizzano” dai tre esempi a un quarto caso.

Questi esercizi ricordano molto i test del QI che si facevano a scuola.

Regole deboli e adattamento

Non sappiamo esattamente come OpenAI abbia raggiunto questo risultato, ma i dati suggeriscono che il modello o3 è altamente adattabile. Con pochi esempi riesce a individuare regole generalizzabili.

Per scoprire uno schema, non bisogna fare ipotesi inutili né essere più specifici del necessario. In teoria, se si identificano le regole “più deboli” che funzionano, si massimizza la capacità di adattarsi a nuove situazioni.

Le regole più deboli sono quelle descrivibili con enunciati più semplici. Per esempio, una regola espressa in linguaggio semplice potrebbe essere: “Qualsiasi forma con una linea sporgente si muove verso l’estremità di quella linea e copre qualsiasi altra forma con cui si sovrappone”.

Catene di pensiero?

Non sappiamo ancora come OpenAI abbia ottenuto questo risultato, ma sembra improbabile che abbiano deliberatamente ottimizzato il sistema o3 per trovare regole deboli. Tuttavia, per avere successo nei compiti ARC-AGI, è probabile che le trovi.

Il ricercatore francese François Chollet, che ha progettato il benchmark, ipotizza che o3 cerchi diverse “catene di pensiero” che descrivono i passaggi per risolvere il compito, scegliendo poi quella “migliore” secondo una regola o “euristica” poco definita.

Questo processo sarebbe simile a quello utilizzato dal sistema AlphaGo di Google, che nel 2016 sconfisse il campione mondiale di Go, Lee Sedol, analizzando diverse sequenze di mosse possibili.

AGI e Intelligenza Artificiale – Cosa non sappiamo ancora

La domanda principale è: siamo davvero più vicini all’AGI? Se il sistema o3 funziona così, il modello sottostante potrebbe non essere molto migliore rispetto ai precedenti.

I concetti appresi dal modello tramite il linguaggio potrebbero non essere più adatti alla generalizzazione rispetto a prima. Potremmo semplicemente osservare una “catena di pensiero” più generalizzabile, trovata grazie a passi di addestramento aggiuntivi per un’euristica specializzata per questo test.

Quasi tutto riguardo a o3 rimane sconosciuto. OpenAI ha condiviso poche informazioni, limitandosi a presentazioni mediatiche e test iniziali con pochi ricercatori, laboratori e istituzioni per la sicurezza dell’IA.

Quando o3 sarà finalmente rilasciato, avremo un’idea più chiara di quanto sia realmente adattabile rispetto alla media umana. Se così fosse, le implicazioni economiche potrebbero essere rivoluzionarie, inaugurando una nuova era di intelligenza accelerata auto-migliorante.

In caso contrario, rimarrebbe comunque un risultato impressionante, ma la vita quotidiana continuerebbe più o meno invariata.